Robotika Dan Etika telah berevolusi jauh dari konsep awalnya sebagai alat bantu manusia dalam produksi industri menjadi entitas otonom yang mampu membuat keputusan sendiri. Teknologi ini kini merambah banyak sektor mulai dari manufaktur, medis, pertanian, hingga pelayanan publik. Perkembangan kecerdasan buatan (AI) dan machine learning membuat robot tidak hanya menjalankan instruksi, tetapi juga dapat belajar dari pengalaman dan memperbaiki diri secara mandiri. Di sinilah muncul dilema etika pertama: ketika mesin diberi kewenangan untuk mengambil keputusan, siapa yang bertanggung jawab jika keputusan itu salah?

Salah satu contoh paling nyata adalah dalam penggunaan kendaraan otonom. Mobil tanpa pengemudi yang terlibat dalam kecelakaan lalu lintas menimbulkan pertanyaan: apakah yang bertanggung jawab adalah pembuat perangkat lunak, produsen mobil, pemilik kendaraan, atau bahkan robot itu sendiri? Dilema ini semakin kompleks seiring dengan semakin meningkatnya kemampuan otonomi dari robot. Ketika algoritma AI membuat keputusan yang menimbulkan kerugian, sistem hukum konvensional kita belum memiliki mekanisme yang jelas untuk menentukan tanggung jawab secara adil.

Di sektor kesehatan, robot bedah yang bekerja tanpa campur tangan langsung dari manusia juga membuka ruang perdebatan. Jika terjadi kesalahan dalam prosedur medis, siapa yang akan dimintai pertanggungjawaban? Dokter, rumah sakit, pembuat robot, atau sistem AI-nya? Kompleksitas ini menunjukkan perlunya perumusan ulang regulasi dan kerangka etika yang dapat mengikuti laju perkembangan teknologi. Ambil contoh kecelakaan yang melibatkan mobil otonom. Jika sistem AI dalam kendaraan membuat keputusan yang salah dan menyebabkan tabrakan, apakah tanggung jawab terletak pada programmer, produsen, pemilik kendaraan, atau AI itu sendiri? Dalam kasus seperti ini, tidak ada jawaban tunggal yang jelas.

Robotika Dan Etika perlu dipahami bahwa algoritma pembelajaran mesin tidak selalu transparan. Sering kali, sistem AI bekerja sebagai “kotak hitam”—pengguna bahkan penciptanya pun tidak selalu bisa menjelaskan bagaimana suatu keputusan diambil. Ketika kesalahan terjadi, menelusuri akarnya menjadi tantangan tersendiri.

Ketimpangan Regulasi Robotika Dan Etika: Hukum Tertinggal Oleh Inovasi

Ketimpangan Regulasi Robotika Dan Etika: Hukum Tertinggal Oleh Inovasi. Sementara teknologi robotika terus berkembang dengan pesat, regulasi yang mengatur penggunaannya justru tertinggal jauh. Banyak negara masih belum memiliki peraturan yang secara eksplisit mengatur tanggung jawab hukum dalam konteks robotika dan AI. Bahkan di negara-negara maju, kebijakan yang ada cenderung bersifat reaktif—baru dibuat setelah terjadi insiden besar.

Ketimpangan ini menciptakan ruang abu-abu yang merugikan semua pihak. Konsumen menjadi rentan karena tidak memiliki perlindungan hukum yang memadai. Pengembang dan produsen juga berisiko menghadapi tuntutan hukum yang tidak pasti. Ketika tidak ada standar hukum yang jelas, pengadilan sering kali harus membuat keputusan berdasarkan interpretasi, yang bisa berbeda antara satu kasus dengan kasus lain.

Perlu diingat bahwa teknologi tidak mengenal batas negara. Robot yang dikembangkan di Jepang bisa dijual dan digunakan di Eropa, dengan sistem hukum yang berbeda. Oleh karena itu, muncul kebutuhan untuk menyusun standar internasional dalam bidang etika dan hukum robotika. Organisasi seperti ISO, IEEE, dan bahkan PBB telah memulai upaya ke arah ini, namun harmonisasi kebijakan global masih menghadapi banyak tantangan, termasuk perbedaan budaya, kepentingan ekonomi, dan kapasitas teknologi.

Tak kalah penting adalah keterlibatan publik dalam proses perumusan regulasi ini. Diskusi mengenai etika robotika seharusnya tidak hanya melibatkan teknolog dan pembuat kebijakan, tetapi juga masyarakat luas sebagai pengguna dan pihak yang terdampak. Keterbukaan, partisipasi, dan akuntabilitas harus menjadi prinsip utama dalam merancang kebijakan masa depan.

Siapa Yang Mengontrol? Kepemilikan, Tanggung Jawab, Dan Transparansi

Siapa Yang Mengontrol? Kepemilikan, Tanggung Jawab, Dan Transparansi. Ketika robot semakin otonom, muncul pertanyaan kritis: siapa yang benar-benar mengendalikan mereka? Dalam banyak kasus, robot tidak bekerja secara sepenuhnya independen, tetapi berdasarkan algoritma dan data yang di tanamkan oleh pengembang. Namun, kompleksitas sistem sering kali membuat proses pengambilan keputusan oleh robot menjadi tidak sepenuhnya dapat di prediksi.

Kondisi ini menyulitkan penetapan tanggung jawab. Misalnya, jika sebuah robot layanan pelanggan memberikan saran medis yang keliru berdasarkan data pengguna, siapa yang harus bertanggung jawab? Perusahaan pengembang, pemilik data, penyedia platform, atau individu yang mengoperasikannya? Model tanggung jawab berlapis seperti ini belum banyak di atur secara rinci dalam hukum.

Transparansi algoritma menjadi kunci utama dalam menangani isu ini. Sayangnya, banyak perusahaan teknologi yang menjadikan kode dan sistem algoritmanya sebagai rahasia dagang. Padahal, dalam konteks pelayanan publik atau interaksi dengan manusia secara luas, transparansi dan audit algoritmik seharusnya menjadi standar.

Penguatan regulasi juga perlu di ikuti dengan literasi digital yang tinggi di masyarakat. Pengguna harus memahami batasan dan kemampuan robot yang mereka gunakan. Selain itu, kontrak kepemilikan dan penggunaan juga harus di atur dengan tegas agar tidak ada kebingungan saat terjadi kegagalan sistem.

Untuk menjawab pertanyaan tentang kontrol, di butuhkan sistem pengawasan (oversight) yang kuat. Pemerintah, badan independen, dan bahkan komunitas pengguna bisa memainkan peran sebagai pengawas untuk memastikan teknologi berjalan sesuai dengan norma hukum dan sosial. Salah satu ide yang mulai berkembang adalah pembentukan “dewan etika teknologi” di berbagai negara yang bertugas mengevaluasi sistem AI dan robotik secara berkala.

Etika Dalam Desain: Membangun Robot Dengan Nilai Manusia

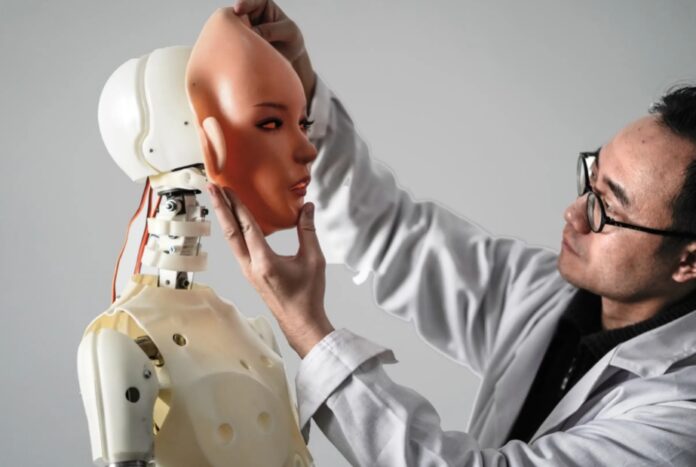

Etika Dalam Desain: Membangun Robot Dengan Nilai Manusia. Salah satu pendekatan yang kini banyak di perbincangkan adalah “ethics by design”—yakni mengintegrasikan prinsip etika ke dalam tahap perancangan teknologi. Pendekatan ini menuntut agar para insinyur, desainer, dan pengembang tidak hanya fokus pada kinerja teknis, tetapi juga pada nilai-nilai moral dan sosial yang melekat dalam setiap keputusan sistem.

Sebagai contoh, dalam pengembangan kendaraan otonom, harus ada keputusan algoritmik yang mengatur skenario kecelakaan tak terhindarkan. Apakah mobil harus menyelamatkan penumpang dengan mengorbankan pejalan kaki, atau sebaliknya? Ini adalah bentuk dilema etis yang di sebut “trolley problem.” Jawaban terhadap pertanyaan ini bisa berbeda-beda tergantung nilai sosial di setiap negara atau budaya.

Lebih dari itu, desain etis juga berarti menjamin inklusivitas dan keadilan. Robot tidak boleh di desain dengan bias yang memperkuat diskriminasi ras, gender, atau status sosial. Sayangnya, banyak studi menunjukkan bahwa data pelatihan AI sering kali mencerminkan bias yang ada dalam masyarakat, yang kemudian di perkuat dalam sistem otomatis.

Untuk menghindari hal ini, kolaborasi lintas disiplin sangat di butuhkan. Teknolog perlu bekerja sama dengan ahli etika, hukum, sosiolog, dan komunitas pengguna. Hanya dengan pendekatan holistik inilah kita dapat menciptakan teknologi robotika yang benar-benar selaras dengan nilai-nilai kemanusiaan.

Akhirnya, meskipun tantangan etika dan hukum dalam dunia robotika sangat kompleks, pendekatan yang bertanggung jawab dan transparan dapat menjadi solusi. Dengan mengedepankan nilai moral dalam desain, memperkuat regulasi, dan memberdayakan masyarakat sebagai pemilik teknologi, kita bisa memastikan bahwa robot bukan hanya alat yang canggih, tetapi juga mitra yang etis dan aman bagi masa depan umat manusia dalam Robotika Dan Etika.